Avant la session conclusive du programme en avril, cette dernière session d’exploration était consacrée à la question de l’évaluation. Pourquoi et pour qui évalue-t-on ? Une session qui nous a permis de changer de regard sur l’évaluation, et d’y voir une alliée pour produire une connaissance plus transformatrice, plutôt qu’une démarche contrainte telle qu’elle est souvent présentée.

Un point de départ : la transition écologique et sociale dans le Nord-Pas de Calais

Pour nous éclairer, nous avions convié Thomas Delahais (Quadrant conseil) et François Jégou (Strategic Design Scenarios) qui se sont rencontrés sur le programme de transformation écologique et sociale de la région Nord-Pas-de-Calais (TESR) en 2013. Le designer, François, accompagnait la démarche pour essayer de faire « marcher le truc », tandis que l’évaluateur, Thomas, cherchait à comprendre si cela marchait vraiment. La TESR partait d’une réflexion théorique : l’idée que, pour traiter de problèmes complexes tels que la rénovation énergétique ou le diabète, iil fallait que les parties prenantes réinterrogent collectivement leurs intérêts pour se “réagencer” au service de finalités communes. Encore fallait-il mettre cela en pratique… Cette initiative d’innovation publique était sous le feu des critiques, qui lui reprochaient sa dimension très conceptuelle. Mais l’évaluation a montré qu’en réalité, de nombreux processus de changement avaient été engagés avec la TESR, et qu’il y avait beaucoup à en apprendre. L’évaluation a ainsi abouti à une nouvelle théorie de la transformation, cette fois-ci empreinte de la pratique des agents et des autres acteurs qui s’y étaient essayés. L’évaluation d’autres démarches de transition a suivi : Loos-en-Gohelle, Grande-Synthe, Fourmies, et plus récemment le projet Isopolis à la Réunion. Un point commun, c’est que ces démarches, l’innovation publique n’est jamais en position seule de faire face à des enjeux qui la dépassent. En revanche toute structure peut jouer un rôle dans un ensemble plus vaste, et il est possible d’évaluer ce rôle.

Dépasser nos a priori sur l’évaluation

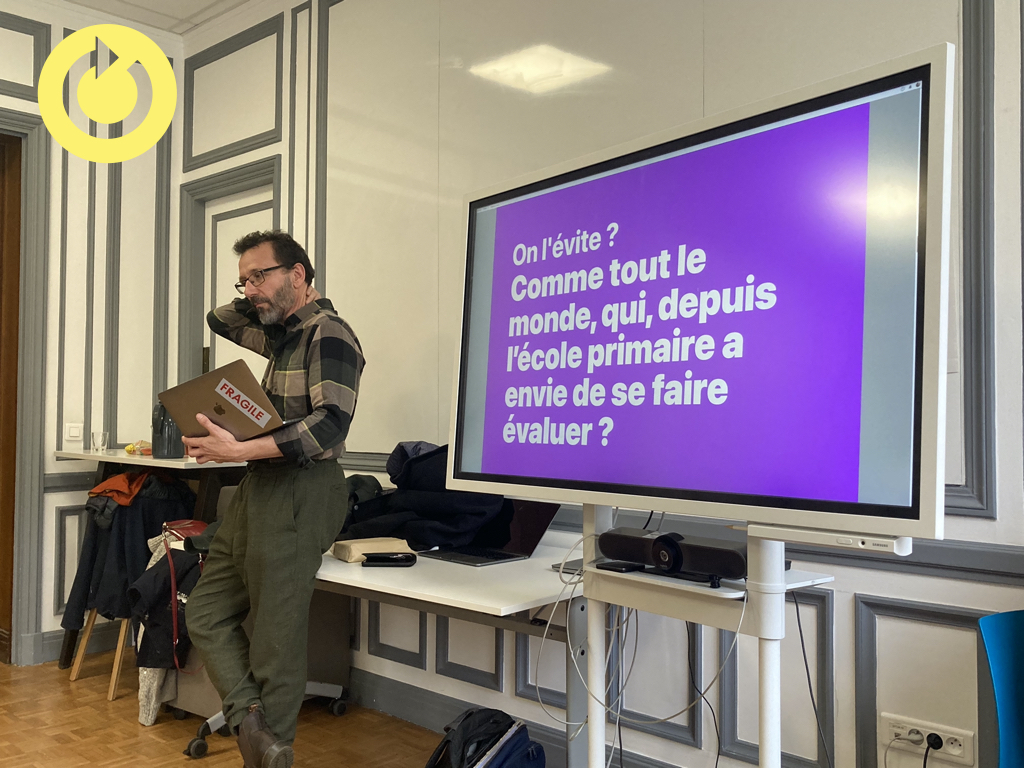

Mais l’évaluation n’a pas une très bonne image. Le problème est psychologique, à tel point que Quadrant Conseil et SDS en ont tiré un jeu de cartes, Evalouaphobia, qui part des a priori les plus fréquents sur l’évaluation : l’impression de sanction, le mythe de la neutralité de l’évaluateur, etc. Or, l’évaluation est une pratique vieille de 50 à 60 ans, en réalité très diverse et qui ne se résume pas aux pratiques de la Cour des Comptes ou des grands cabinets de conseil, peu adaptée à l’innovation et à la complexité. . Pour Thomas Delahais, il y a souvent confusion entre évaluation et d’autres pratiques que sont l’audit et la mesure de la performance, qui sont guidées par la conformité à des objectifs préétablis. Or, ce qui intéresse l’évaluation, ce sont les conséquences concrètes (les résultats) des innovations engagées, que celles-ci soient attendues ou non.

Re-politiser, re-théoriser avec l’évaluation

Mais comment déterminer les résultats des innovations, en particulier lorsqu’elles sont immatérielles ? Une façon de procéder, c’est d’élaborer une “théorie du changement” : c’est-à-dire de rendre explicites toutes les hypothèses que l’on fait sur des actions menées et la manière dont elles ont des effets. Par exemple, comment, pourquoi, dans quels cas le soutien d’un lab à un projet va déboucher sur des changements de pratiques dans l’administration. Une fois ces hypothèses posées (pourquoi pas collectivement ?), il sera possible de les tester en s’appuyant sur une collecte empirique.

Enfin, l’évaluation est une activité de jugement, qui regarde donc les actions menées à travers des critères spécifiques. Ces derniers sont vraiment au cœur de la pratique évaluative. D’abord, parce que c’est l’expression de ces critères qui va permettre de considérer qu’une intervention est bonne, suffisante, ou insuffisante… Mais aussi parce que tous les acteurs autour de la table n’ont pas les mêmes ( (c’est politique), et qu’ils peuvent évoluer au fil du temps (d’autant plus avecl’innovation !). Par exemple, on ne jugera pas de la même façon un lab si c’est au regard d’un critère de communication extérieure au service de l’image de l’administration, de renforcement des capacités des agents ou bien encore de changement durable des pratiques… Raison de plus pour ne pas se laisser déposséder d’une discussion sur les critères !

Bref, évaluer peux nous aider pour alimenter deux de nos mantras des Labonautes : (re)politiser et (re)théoriser.

| Pour approfondir :

« S’appuyant sur les travaux de l’analyse des politiques publiques et de la sociologie de l’action publique, cette démarche propose une évaluation intégrée à son contexte politique prenant en compte son fonctionnement. La théorie peut alors devenir un outil structurant de l’évaluation contribuant à ouvrir la « boîte noire » des politiques publiques, fédérer l’apprentissage des acteurs publics, établir la causalité et même construire la transférabilité des résultats d’évaluation à d’autres contextes en s’inscrivant dans une épistémologie réaliste. » L’évaluation « basée sur la théorie », entre rigueur scientifique et contexte politique, Agathe DEVAUX-SPATARAKIS, Politiques & management public, 2014 Et une ressource de nos collègues canadiens jamais en retard : Approches d’évaluation axées sur la théorie : Concepts et pratiques (Secrétariat du Conseil du Trésor du Canada) |

Evaluer doit aussi être utile et amener du changement

Un enjeu majeur de l’évaluation, enfin, c’est d’être utile. Or il y a plusieurs façons de l’être : on pense bien sûr d’abord à une évaluation complète. Il y en a de nombreux types, indépendante, managériale (c’est-à-dire en soutien à la direction du projet), mais aussi participative (ce qui veut dire donner aux parties prenantes du pouvoir sur le processus évaluatif)… Dans tous les cas, l’apport de l’évaluation sera alors de recourir à plusieurs outils, de multiplier les perspectives pour apporter un nouveau regard sur l’action. Contrairement à la recherche, l’évaluation s’adapte aux contraintes de temps, budget et de données pour disponibles et cherche un compromis pour rester utile aux parties prenantes.

Une autre logique, cependant, peut être de se placer dans une posture évaluative. Adopter la posture évaluative, c’est en quelque sorte regarder l’action à travers les yeux d’un·e évaluateur/rice : quel était le problème à résoudre, quelles solutions sont proposées, ont-elles une véritable chance d’avoir un effet, dans quels cas ? Et quelles sont les conséquences effectivement constatées, qu’a-t-on appris de l’action ? Cette casquette d’évaluateur/rice, tout le monde peut la porter à un moment donné du projet, avec des apports précieux pour la suite.

L’évaluation vue par le design

François Jegou évoque les freins à l’évaluation pour les innovateurs :

- avoir l’impression de passer plus de temps à regarder si ce qui a été produit a marché que d’essayer de le faire marcher.

- se méfier : est-elle bienveillante, encourageante, regardant le positif et pas que le négatif ? Car dans l’innovation, il est important de se consacrer aux 5 % qui marchent et pas seulement aux 95 % qui ne marchent pas, pour essayer de préserver les choses en gestation qui vont peut-être apporter des solutions.

- ne pas comprendre les méthodes

- avoir l’impression qu’elle arrive trop tard, comme la cavalerie

Quelles pistes pour évaluer l’innovation publique ?

En conclusion, ces éléments peuvent se traduire dans 3 approches d’évaluation des labs :

- Approche de suivi-évaluation : la plus classique, elle consiste à se donner des éléments pour rendre compte des résultats de l’action en lien avec ses résultats attendus. Une collecte annuelle permet de disposer d’éléments pour rendre compte et défendre le travail effectué. Attention toutefois à ne pas utiliser des critères dominants (de performance, de satisfaction…) au regard desquels l’innovation sortira perdante à tous les coups

- Approche d’enquête ouverte : Ce qui caractérise certains labs, c’est une multiplicité d’effets inattendus, en lien avec la grande diversité des actions qu’ils entreprennent. Une récolte ouverte des effets consiste à aller documenter systématiquement les changements qui suivent le travail du lab et à comprendre le rôle qu’y a joué le lab. Idéalement, on dépassera la collection d’anecdotes en allant enquêter de manière systématique, à charge et décharge, sur ces effets

- Approche d’analyse de contribution. C’est une approche qui ne s’emploie que ponctuellement. Enrepartant des changements constatés dans l’administration, ou dans la réponse à des problèmes publics, on cherchera à caractériser ce qui a contribué à la transformation, soit les labs… mais potentiellement également bien d’autres facteurs. Cette approche repart alors de ce qui compte (le transformation) pour définir le rôle de l’innovation publique parmi d’autres – et peut-être identifier où, comment, dans quels cas, son apport s’est matérialisé… mais aussi quels sont les autres vecteurs du changement sur lesquels s’appuyer.

Dans ces deux dernières approches, évaluer vient alimenter nos 3e mantras des Labonautes : (ré)ouvrir.

Premier témoignage de labos : Erwin Riclet, La Fabrique à projets (MTE)

La Fabrique à projets a anticipé et commandé soi-même une évaluation, plutôt que de risquer d’en subir une imposée selon d’autres termes.

Le cadre de l’évaluation était les activités du lab : Accompagnement de projet, accompagnement coup de pouce, sensibilisation et formation

Elle a été réalisée en équipe (6 personnes) avec l’appui d’une agence :

- poser clairement les finalités (ce qui n’avait pas été formalisé entre 2018 et 2021), ce qui a pris 6 mois avec beaucoup d’itérations avec les stratégies de service, direction,…

- travailler sur les questions évaluatives et indicateurs / itération avec les outils de collecte de données pour s’assurer de ce qui est collectable

- tester le dispositif

- arbre des objectifs:

- logique de contribution à l’objectif général

- regard plus précis sur la contribution aux objectifs stratégique

- indicateurs

- outils d’évaluation à chaud et à froid

- schéma de pilotage :

- évaluation à différentes échelles de parties prenantes et échéance

Deuxième témoignage de labos : Silvère Mercier, Métropole Européenne de Lille

A partir de la collecte de perles sur le terrain, le lab constatait qu’il produisait des effets : « On est des adjuvants des projets. ».

Il y a eu un travail de modélisation de l’action du lab qui a permis d’identifier que les productions du lab ont 3 types d’effet, qui se répartissent en 1/3 – 1/3 – 1/3 :

- effet direct : impact du projet

- effet méthodologique : essaimage méthodologique

- effet transversal : meilleure connaissances des partenaires

D’autres effets sont proposés lors des échanges avec les labonautes : effet stratégique (prise en compte par la DG, voir ci-dessous), effet de connaissance produite capitalisable pour d’autres projets, effet d’apprentissage de l’équipe.

Par ailleurs, la maturité des démarches de conception (design) est mesurée par le nombre de directions métiers impliquées. De plus, plusieurs opérations atteignent des budgets de plus de 100K€ et se rapprochent de enjeux stratégiques du mandat. Cet effet stratégique se traduit par la récente intégration du lab dans la direction R&D.

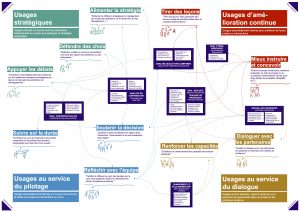

Les usages de l’évaluation

Thomas Delahais introduit l’après-midi en nous partageant une cartographie des usages de l’évaluation, fruit d’une collaboration de recherche menée en 2021-2022 entre l’Agence Française de Développement, Quadrant Conseil et Strategic Design Scenarios. Cela aide à clarifier l’utilité recherchée en mobilisant l’évaluation.

Evaluer les labs à partir de leurs usages ?

Nous poursuivons avec un travail en atelier pour essayer de définir quels sont les usages des labs, c’est-à-dire comment et pourquoi les acteurs qui font appel à des propositions du labs les utilisent.

Lors du débriefing, on constate qu’il y a beaucoup d’usages listés :

- Lesquels sont vraiment effectifs ? Ou passés, ou souhaités ?

- Quelle part représentent les divers usages ?

- Lesquels soutient-on, encourage-t-on ? Lesquels décourage-t-on ?

- Subit-on ou est-on acteur des changements d’usages ?

- Les usages évoluent-ils en fonction de la maturité des acteurs ?

Le passage des usages identifiés au effets produits n’est pas facile. C’est là que les théories du changement sont à construire :

- Agrégation de projets qui à terme marque une transformation.

- Soutien à un dynamique qui prend de l’ampleur dans la collectivités.

- Constituer une culture nouvelle.

- …

Plusieurs chemins peuvent se combiner : on peut avoir plusieurs théories du changement.

Le but est d’avoir une grammaire pour réfléchir à ce que l’on fait : apporter le dialogue sur ce que peut l’innovation dans une organisation publique, y compris avec d’autres acteurs de la transformation.

Alors que les Labonautes se penchent sur le futur des labs, plusieurs questions sont soulevées :

- beaucoup d’usages semblent jouer sur le côté « nouveauté » qui suscite curiosité et acceptation d’essai : or, cela ne va durer. Quel avenir pour ces usages qui ne seront bientôt plus « nouveaux » ?

- pourquoi parle-t-on de maturité voire (c’est de saison) de retraite des labs, alors qu’on ne parle pas de cela pour des services finances par exemple ?

- est-on le bon lab adapté au bon contexte avec les bonnes finalités ?

Et dire qu’il ne reste qu’une session à venir. A croire que si le début du chemin aura été balisé, l’exploration collective sera à poursuivre. Nous aurons à en reparler prochainement !